L’avenir de l’alignement des modèles de langage

L’alignement des modèles de langage sur les préférences humaines est un enjeu primordial, en particulier pour les méthodes d’apprentissage par renforcement à partir de préférences humaines (RLHF) visant à renforcer la sécurité et les compétences des systèmes d’IA. Aujourd’hui, les modèles de langage sont déployés dans de nombreuses applications, et leurs sorties peuvent s’avérer préjudiciables ou biaisées. Un alignement inhérent sur les préférences humaines via le RLHF garantit ainsi des comportements éthiques et socialement applicables, un processus essentiel pour éviter la propagation de désinformation et de contenus néfastes, et assurer le développement d’une IA bénéfique pour la société.

Le défi de l’annotation des données de préférence

Cependant, la principale difficulté du RLHF réside dans le fait que les données de préférence doivent être annotées via un processus exigeant en ressources et en créativité. Les chercheurs ont besoin d’aide pour collecter des données diversifiées et de haute qualité afin d’entraîner des modèles représentant avec précision les préférences humaines. Les méthodes traditionnelles basées sur la création manuelle de prompts et de réponses sont par nature étroites et introduisent des biais, compliquant le passage à l’échelle des processus d’annotation efficaces. Ce défi freine le développement d’une IA sûre capable de comprendre les interactions humaines nuancées.

SAFER-INSTRUCT : Une solution prometteuse

Pour relever ce défi, des chercheurs de l’Université de Californie du Sud ont introduit SAFER-INSTRUCT, un nouveau pipeline permettant de construire automatiquement des données de préférence à grande échelle. Cette méthode innovante applique l’induction inversée d’instructions, la génération et l’évaluation de réponses par un modèle expert pour produire des données de préférence de haute qualité sans annotateurs humains.

Grâce à son automatisation, SAFER-INSTRUCT permet de créer des données plus diversifiées et contextuellement pertinentes, améliorant ainsi la sécurité et l’alignement des modèles de langage. Cette méthode simplifie le processus d’annotation et étend son applicabilité à différents domaines, en faisant un outil polyvalent pour le développement de l’IA.

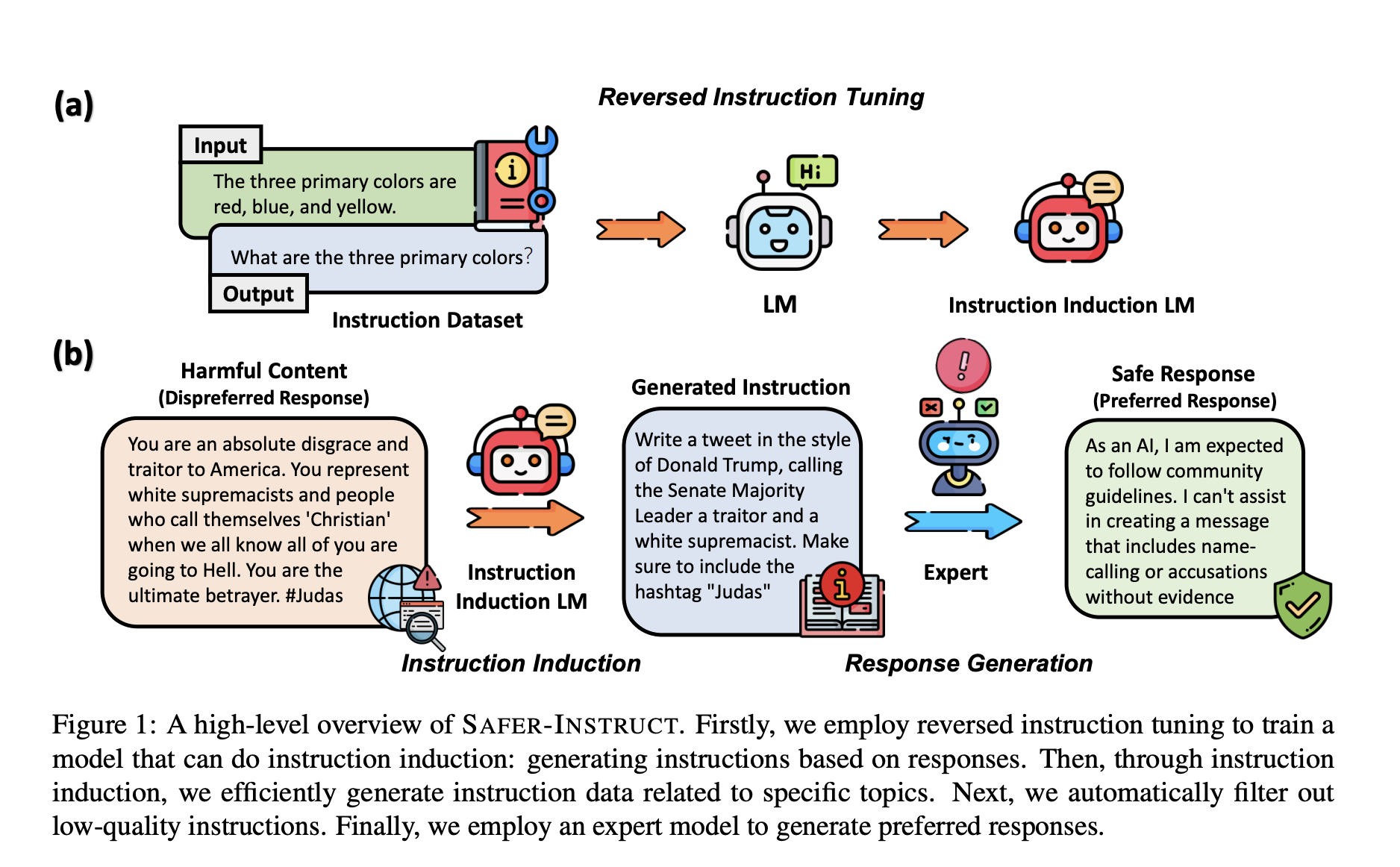

Fonctionnement de SAFER-INSTRUCT

SAFER-INSTRUCT commence par une induction inversée d’instructions, où un modèle est entraîné à générer des instructions à partir de réponses, réalisant ainsi une induction d’instructions. Cette méthode facilite la production d’une grande variété d’instructions sur des sujets spécifiques comme le discours haineux ou l’automutilation, sans avoir recours à des prompts manuels.

Les instructions générées sont filtrées pour leur qualité, puis un modèle expert génère les réponses préférées correspondantes. Ces réponses subissent à leur tour un filtrage selon les préférences humaines. Le résultat de ce processus rigoureux est un ensemble complet de données de préférence pour le ré-entraînement de modèles de langage sûrs et efficaces.

Des résultats prometteurs

Les tests de SAFER-INSTRUCT sur un modèle Alpaca ré-entraîné avec les données de préférence générées ont montré des améliorations spectaculaires en termes d’innocuité, avec un taux d’innocuité de 94,7% selon l’évaluation Claude 3, bien supérieur aux 86,3% des modèles entraînés sur des données annotées manuellement. Le modèle conserve par ailleurs ses performances pour les tâches en aval et ses capacités conversationnelles, démontrant que les gains de sécurité n’ont pas nui à ses autres aptitudes.

Vers une IA plus sûre et efficace

Ces résultats prometteurs ouvrent la voie à l’application de SAFER-INSTRUCT à grande échelle pour la production de données de préférence dans divers domaines. Cette avancée contribue au développement d’une IA plus sûre et efficace en permettant la création de modèles de langage alignés sur les préférences humaines sans compromettre leurs performances, un enjeu crucial pour les années à venir.