Décryptage : Les modèles de langage peuvent-ils réellement comprendre les programmes de rendu visuel ?

Les grands modèles de langage (LLMs) ont démontré leur capacité à générer du code informatique générique, témoignant d’une certaine compréhension de la structure des programmes. Cependant, une question reste en suspens : peuvent-ils vraiment comprendre les programmes de graphiques symboliques, qui génèrent du contenu visuel lorsqu’ils sont exécutés ?

Au-delà de la simple génération de code

Cette compréhension est définie comme la capacité à saisir le contenu sémantique de l’image rendue, sur la base du seul texte brut du programme, sans en voir le rendu visuel. Une tâche aisée pour l’œil humain, mais nettement plus complexe pour un modèle de langage qui doit s’appuyer uniquement sur le code textuel.

Des programmes uniques aux significations visuelles

Les programmes de graphiques symboliques sont des représentations interprétables de contenus visuels, utilisées notamment dans :

- La géométrie de construction solide (CSG) pour modéliser des formes 2D et 3D

- La conception assistée par ordinateur (CAO) pour la modélisation 2D et 3D

- Les graphiques vectoriels évolutifs (SVG) pour des représentations 2D

Contrairement aux tâches de programmation classiques, la signification sémantique de ces programmes est souvent définie visuellement, ce qui les rend uniques à évaluer pour les LLMs.

Une nouvelle approche pour évaluer les LLMs

Des chercheurs ont proposé une nouvelle approche pour évaluer et améliorer la compréhension par les LLMs des programmes de graphiques symboliques.

SGP-Bench : Un benchmark dédié

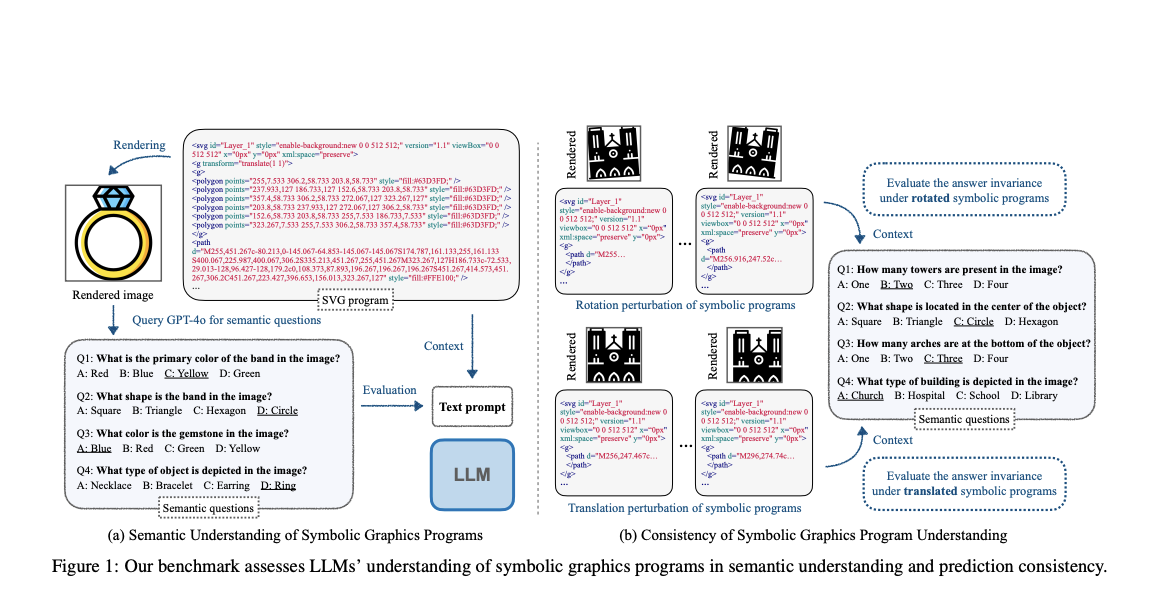

Ils ont introduit SGP-Bench, un benchmark permettant d’évaluer la compréhension sémantique et la cohérence des LLMs dans l’interprétation des programmes SVG (2D) et CAO (2D/3D). Ce benchmark fonctionne grâce à un pipeline efficace utilisant un modèle vision-langage pour générer des questions à partir d’images, validées par des annotateurs humains.

Symbolic Instruction Tuning : Une méthode d’amélioration

Les chercheurs ont également développé Symbolic Instruction Tuning (SIT), une nouvelle méthode de fine-tuning basée sur un ensemble d’instructions symboliques, visant à améliorer les performances des LLMs sur cette tâche.

Des résultats révélateurs

Les performances des LLMs ont été évaluées sur le dataset SGP-MNIST, constitué de 1 000 programmes SVG rendant des chiffres MNIST. Alors que les humains reconnaissent facilement ces images, les LLMs ont rencontré d’immenses difficultés à interpréter ces programmes symboliques. Même le modèle avancé GPT-4o n’a performé que légèrement mieux qu’un choix aléatoire.

Cet écart abyssal entre les performances humaines et celles des LLMs met en lumière les limites actuelles de ces modèles dans la compréhension des représentations symboliques d’informations visuelles. Cette recherche encourage le développement de nouvelles tâches d’évaluation variées, et ouvre la voie à de futurs travaux visant à mieux comprendre ces mécanismes et à améliorer les performances des LLMs dans ce domaine.