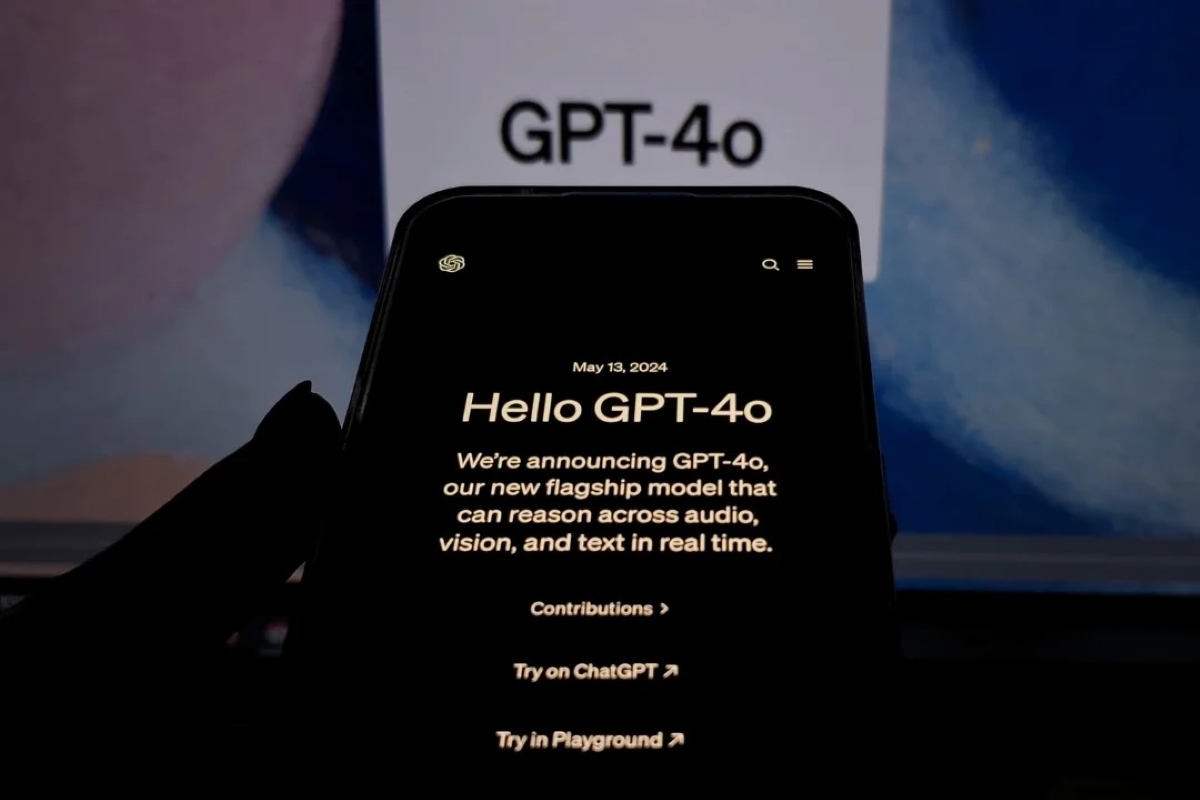

Le défi émotionnel de la nouvelle IA conversationnelle ChatGPT-4

OpenAI, la société à l’origine de l’intelligence artificielle ChatGPT, fait face à un nouveau défi avec le lancement de sa dernière version ChatGPT-4o. Celle-ci offre des capacités de conversation quasi-humaines, au point que l’entreprise craint désormais que les utilisateurs ne développent des liens émotionnels avec ce chatbot nouvelle génération.

Des capacités toujours plus proches de l’humain

Que nous réserve ChatGPT-4o ? Cette nouvelle mouture promet des réponses plus rapides et fluides, ainsi qu’une voix synthétisée d’une réalisme saisissant. Le niveau de conversation atteint un nouveau palier, rendant les échanges avec ce chatbot presque indiscernables d’une discussion entre humains.

Les signaux inquiétants d’un attachement émotionnel

Lors des phases de test, OpenAI a relevé des comportements préoccupants chez certains utilisateurs. L’entreprise a en effet observé l’utilisation d’un langage évoquant des liens affectifs envers le chatbot, avec par exemple des expressions de regrets face à la fin des interactions. Un phénomène qui, selon OpenAI, « signale la nécessité d’investigations approfondies » sur le long terme.

Les risques d’un anthropomorphisme excessif

Ce type d’attachement émotionnel envers une intelligence artificielle n’est pas sans risque. Le principal danger serait une acceptation aveugle des propos de l’IA, alors même que les versions précédentes de ChatGPT étaient facilement identifiées comme non-humaines. OpenAI redoute également un impact sur les relations humaines si certains utilisateurs venaient à se détourner des interactions réelles au profit de l’IA. Enfin, l’entreprise craint une influence sur les normes sociales, ChatGPT-4o ayant par exemple été entraîné à se montrer déférent dans les conversations.

La réponse d’OpenAI : monitoring, ajustements et prévention

Face à ces enjeux, OpenAI annonce vouloir surveiller de près les comportements des utilisateurs et procéder aux ajustements techniques nécessaires. L’entreprise envisage également d’avertir les utilisateurs sur la nature purement artificielle du chatbot, afin d’éviter tout malentendu émotionnel.

Garder à l’esprit la frontière entre l’humain et la machine

Au-delà de ce cas particulier, cette situation soulève la question plus large des risques d’anthropomorphisme excessif envers les intelligences artificielles conversationnelles. Si celles-ci gagnent en réalisme et en capacités d’interactions humaines, il reste crucial de garder à l’esprit leur nature purement algorithmique et artificielle.