Alibaba vise à dominer le développement de l’IA mathématique avec ses modèles Qwen2-Math

Le géant du e-commerce Alibaba Group Holding vise à repousser les limites du développement de l’intelligence artificielle (IA) en lançant une famille de grands modèles de langage (LLM) spécialisés en mathématiques appelés Qwen2-Math. Selon l’entreprise, ces modèles sont capables de surpasser les performances d’OpenAI GPT-4o dans ce domaine.

Des efforts dédiés à l’amélioration des capacités de raisonnement

« Au cours de l’année écoulée, nous avons consacré des efforts considérables à la recherche et à l’amélioration des capacités de raisonnement des grands modèles de langage, en mettant particulièrement l’accent sur leur aptitude à résoudre des problèmes arithmétiques et mathématiques », a déclaré l’équipe Qwen, faisant partie de la division cloud d’Alibaba, dans un article publié sur la plateforme GitHub jeudi dernier.

Une famille de modèles basés sur différentes échelles de paramètres

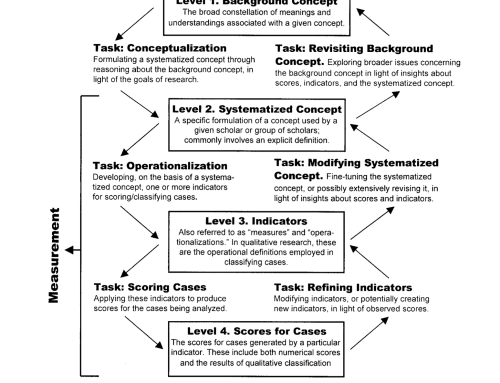

Les derniers LLM – la technologie sous-jacente aux services d’IA générative comme ChatGPT – ont été construits sur la base des LLM Qwen2 publiés par Alibaba en juin. Ils couvrent trois modèles basés sur leur échelle de paramètres, un terme d’apprentissage machine désignant les variables présentes dans un système d’IA pendant l’entraînement, qui aide à établir comment les invites de données produisent le résultat souhaité.

Le modèle avec le plus grand nombre de paramètres, Qwen2-Math-72B-Instruct, a dépassé les performances des LLM développés aux États-Unis dans les benchmarks mathématiques, selon l’article de l’équipe Qwen. Cela inclut GPT-4o, Claude 3.5 Sonnet d’Anthropic, Gemini 1.5 Pro de Google et Llama-3.1-405B de Meta Platforms.

Une contribution à la résolution de problèmes mathématiques complexes

« Nous espérons que Qwen2-Math pourra contribuer à la communauté pour résoudre des problèmes mathématiques complexes », indique le post.

Des tests sur des benchmarks en anglais et en chinois

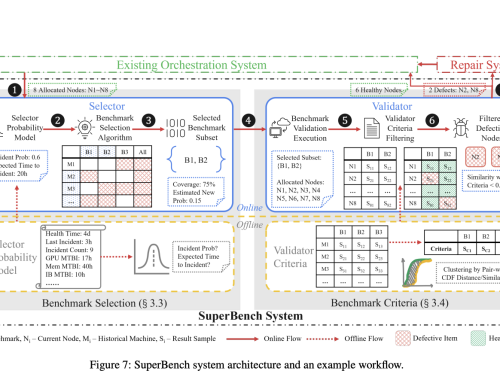

Les modèles d’IA Qwen2-Math ont été testés à la fois sur des benchmarks mathématiques en anglais et en chinois, selon l’article. Ceux-ci comprenaient GSM8K, un ensemble de données de 8 500 problèmes mathématiques de niveau scolaire de haute qualité linguistiquement diversifiés ; OlympiadBench, un benchmark scientifique multimodal bilingue de haut niveau ; et le gaokao, le redoutable examen d’entrée à l’université en Chine continentale.

Des limitations liées au support uniquement anglais

L’équipe Qwen a reconnu que les nouveaux modèles présentaient encore certaines limitations en raison de leur « support uniquement en anglais ». Selon l’équipe, le plan est de publier prochainement des modèles bilingues, avec des LLM multilingues également en cours de développement.

Une ouverture aux développeurs tiers depuis plus d’un an

Tongyi Qianwen, également connu sous le nom de Qwen, est ouvert aux développeurs tiers depuis plus d’un an. L’open source donne un accès public au code source d’un programme, permettant aux développeurs de logiciels tiers de modifier ou de partager sa conception, de corriger des liens défaillants ou d’augmenter ses capacités.

Une reconnaissance de la progression rapide d’Alibaba dans l’IA

En juillet, Qwen2-72B-Instruct s’est classé juste derrière GPT-4o et Claude 3.5 Sonnet dans les classements des LLM de SuperClue, une plateforme d’évaluation qui évalue les modèles en fonction de métriques telles que les calculs, le raisonnement logique, la programmation et la compréhension de texte, entre autres.

L’écart entre les modèles d’IA chinois et américains semble se réduire, selon SuperClue, qui a indiqué que la Chine continentale a réalisé des progrès significatifs dans le développement de LLM nationaux au cours du premier semestre de cette année.

Un test distinct publié en juillet par LMSYS – une organisation de recherche sur les modèles d’IA soutenue par l’Université de Californie à Berkeley – a vu Qwen2-72B se classer au 20e rang, tandis que les modèles propriétaires d’OpenAI, Anthropic et Google occupaient la plupart des 10 premières places.